A Anthropic está lançando um novo modelo de IA de fronteira chamado Claude 3.7 Sonnet, que a empresa projetou para “pensar” sobre perguntas pelo tempo que os usuários desejarem.

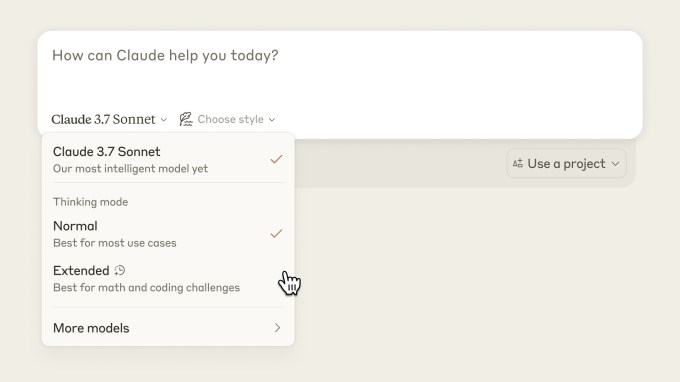

A Anthropic denomina o Claude 3.7 Sonnet como o primeiro “modelo de raciocínio híbrido de IA” da indústria, pois é um modelo único que pode fornecer tanto respostas em tempo real quanto respostas mais ponderadas e “pensadas” para as perguntas. Os usuários podem escolher se desejam ativar as habilidades de “raciocínio” do modelo de IA, o que leva o Claude 3.7 Sonnet a “pensar” por um curto ou longo período de tempo.

O modelo representa o esforço mais amplo da Anthropic para simplificar a experiência do usuário em torno de seus produtos de IA. A maioria dos chatbots de IA hoje possui um seletor de modelo intimidador que força os usuários a escolher entre várias opções diferentes, que variam em custo e capacidade. Laboratórios como a Anthropic preferem que você não precise se preocupar com isso — idealmente, um modelo faz todo o trabalho.

A Claude 3.7 Sonnet está sendo disponibilizada a todos os usuários e desenvolvedores na segunda-feira, disse a Anthropic, mas apenas as pessoas que pagarem pelos planos premium do chatbot Claude terão acesso aos recursos de raciocínio do modelo. Usuários gratuitos do Claude receberão a versão padrão, não raciocinadora, do Claude 3.7 Sonnet, que a Anthropic afirma superar seu anterior modelo de IA de fronteira, o Claude 3.5 Sonnet. (Sim, a empresa pulou alguns números.)

O Claude 3.7 Sonnet custa $3 por milhão de tokens de entrada (o que significa que você pode inserir aproximadamente 750.000 palavras, mais palavras do que toda a série “O Senhor dos Anéis”, no Claude por $3) e $15 por milhão de tokens de saída. Isso o torna mais caro do que o o3-mini da OpenAI ($1,10 por 1 milhão de tokens de entrada/$4,40 por 1 milhão de tokens de saída) e o R1 da DeepSeek (55 centavos por 1 milhão de tokens de entrada/$2,19 por 1 milhão de tokens de saída), mas lembre-se que o o3-mini e o R1 são estritamente modelos de raciocínio — não híbridos como o Claude 3.7 Sonnet.

Claude 3.7 Sonnet é o primeiro modelo de IA da Anthropic que pode “raciocinar”, uma técnica que muitos laboratórios de IA têm adotado à medida que os métodos tradicionais de melhoria do desempenho da IA entram em declínio.

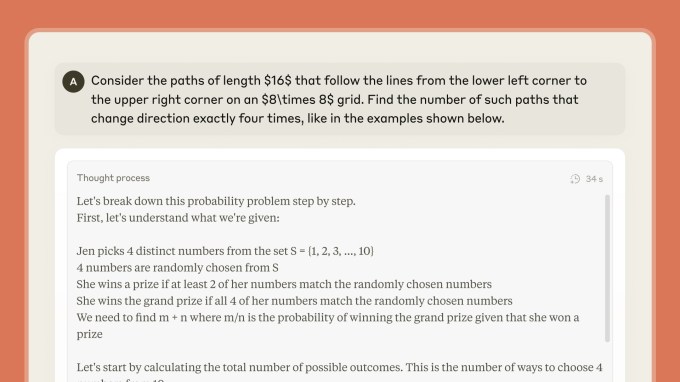

Modelos de raciocínio como o o3-mini, R1, Gemini 2.0 Flash Thinking do Google, e Grok 3 da xAI (Think) utilizam mais tempo e poder computacional antes de responder perguntas. Os modelos dividem problemas em etapas menores, o que tende a melhorar a precisão da resposta final. Modelos de raciocínio não estão pensando ou raciocinando como um humano faria, necessariamente, mas seu processo é modelado após a dedução.

Eventualmente, a Anthropic gostaria que Claude descobrisse por conta própria quanto tempo deve “pensar” sobre perguntas, sem necessidade de os usuários selecionarem controles antecipadamente, disse Dianne Penn, líder de produtos e pesquisa da Anthropic, em entrevista ao TechCrunch.

“Semelhante a como os humanos não têm dois cérebros separados para perguntas que podem ser respondidas imediatamente versus aquelas que requerem reflexão,” escreveu a Anthropic em um postagem de blog compartilhada com o TechCrunch, “consideramos o raciocínio como simplesmente uma das capacidades que um modelo de fronteira deveria ter, para ser suavemente integrado com outras capacidades, em vez de ser algo fornecido em um modelo separado.”

A Anthropic afirma que está permitindo que Claude 3.7 Sonnet mostre sua fase de planejamento interno através de um “bloquinho visível”. Penn disse ao TechCrunch que os usuários verão todo o processo de pensamento do Claude para a maioria dos prompts, mas que algumas partes podem ser redigidas por motivos de confiança e segurança.

A Anthropic afirma que otimizou os modos de pensamento do Claude para tarefas do mundo real, como problemas de codificação difíceis ou tarefas agentivas. Desenvolvedores que acessam a API da Anthropic podem controlar o “orçamento” para pensar, trocando velocidade e custo pela qualidade da resposta.

Em um teste para medir tarefas de codificação do mundo real, SWE-Bench, o Claude 3.7 Sonnet teve 62,3% de precisão, comparado ao modelo o3-mini da OpenAI, que registrou 49,3%. Em outro teste para medir a capacidade de um modelo de IA de interagir com usuários simulados e APIs externas em um cenário de varejo, TAU-Bench, o Claude 3.7 Sonnet obteve 81,2%, em comparação ao modelo o1 da OpenAI, que teve 73,5%.

A Anthropic também afirma que o Claude 3.7 Sonnet se recusará a responder perguntas com menor frequência do que seus modelos anteriores, alegando que o modelo é capaz de fazer distinções mais nuançadas entre prompts prejudiciais e benignos. A Anthropic diz que reduziu as recusas desnecessárias em 45% em comparação ao Claude 3.5 Sonnet. Isso ocorre em um momento em que alguns outros laboratórios de IA estão repensando sua abordagem para restringir as respostas de seus chatbots de IA.

Além do Claude 3.7 Sonnet, a Anthropic também está lançando uma ferramenta de codificação agentiva chamada Claude Code. Lançada como um preview de pesquisa, a ferramenta permite que desenvolvedores executem tarefas específicas pelo Claude diretamente de seu terminal.

Em uma demonstração, funcionários da Anthropic mostraram como o Claude Code pode analisar um projeto de codificação com um comando simples como, “Explique esta estrutura de projeto.” Usando inglês simples na linha de comando, um desenvolvedor pode modificar uma base de código. O Claude Code descreverá suas edições enquanto faz mudanças e até testará um projeto em busca de erros ou o enviará para um repositório GitHub.

O Claude Code estará inicialmente disponível para um número limitado de usuários por uma base de “primeiro a chegar, primeiro a ser servido”, disse um porta-voz da Anthropic ao TechCrunch.

A Anthropic está lançando o Claude 3.7 Sonnet em um momento em que laboratórios de IA estão lançando novos modelos de IA a um ritmo acelerado. A Anthropic tradicionalmente adotou uma abordagem mais metódica e focada na segurança. Mas, desta vez, a empresa está buscando liderar o setor.

Mas por quanto tempo, essa é a questão. A OpenAI pode estar próxima de lançar um modelo de IA híbrido por conta própria; o CEO da empresa, Sam Altman, disse que ele chegará em “meses.”

Conteúdo relacionado

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…

Tudo o que você precisa saber sobre o chatbot de IA

[the_ad id="145565"] O ChatGPT, o chatbot de IA geradora de texto da OpenAI, conquistou o mundo desde seu lançamento em novembro de 2022. O que começou como uma ferramenta para…