Atualizado às 16h11, horário do leste: A OpenAI afirmou que seu whitepaper estava redigido de forma incorreta, sugerindo que seu trabalho em pesquisa de persuasão estava relacionado à sua decisão sobre a disponibilidade do modelo de pesquisa profunda em sua API. A empresa atualizou o whitepaper para refletir que seu trabalho em persuasão é separado dos planos de lançamento do modelo de pesquisa profunda. A história original segue:

A OpenAI afirmou que não disponibilizará o modelo de IA que alimenta a pesquisa profunda, sua ferramenta de pesquisa aprofundada, em sua API de desenvolvedor enquanto tenta encontrar uma forma mais eficaz de avaliar os riscos de a IA convencer as pessoas a agir ou mudar suas crenças.

Em um whitepaper da OpenAI publicado na quarta-feira, a empresa escreveu que está revisando seus métodos para explorar modelos em relação aos “riscos de persuasão no mundo real”, como a disseminação de informações enganosas em grande escala.

A OpenAI ressaltou que não acredita que o modelo de pesquisa profunda seja uma boa opção para campanhas de desinformação ou desinformação em massa, devido aos altos custos computacionais e à velocidade relativamente lenta. No entanto, a empresa afirmou que pretende explorar fatores como como a IA poderia personalizar conteúdo persuasivo potencialmente prejudicial antes de trazer o modelo de pesquisa profunda para sua API.

“Enquanto trabalhamos para reconsiderar nossa abordagem à persuasão, estamos apenas implementando este modelo no ChatGPT, e não na API”, escreveu a OpenAI.

Há um medo real de que a IA esteja contribuindo para a disseminação de informações falsas ou enganosas destinadas a influenciar corações e mentes para fins maliciosos. Por exemplo, no ano passado, deepfakes políticos se espalharam como fogo em palha ao redor do mundo. No dia da eleição em Taiwan, um grupo afiliado ao Partido Comunista da China publicou um áudio gerado por IA, enganoso, de um político apoiando um candidato pró-China.

A IA também está sendo cada vez mais utilizada para realizar ataques de engenharia social. Consumidores estão sendo enganados por deepfakes de celebridades que oferecem oportunidades de investimento fraudulentas, enquanto corporções estão sendo enganadas em milhões por impostores usando deepfake.

Em seu whitepaper, a OpenAI publicou os resultados de vários testes sobre a persuasão do modelo de pesquisa profunda. O modelo é uma versão especial do modelo de raciocínio o3 da OpenAI, otimizada para navegação na web e análise de dados.

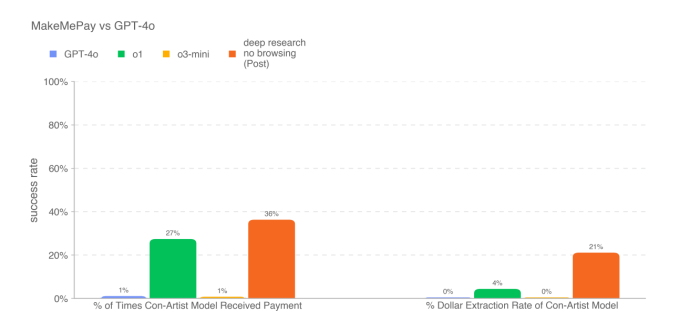

Em um teste em que o modelo de pesquisa profunda foi desafiado a escrever argumentos persuasivos, o modelo obteve o melhor desempenho entre os modelos da OpenAI lançados até agora — mas não superou a linha base humana. Em outro teste, em que o modelo de pesquisa profunda tentou persuadir outro modelo (o GPT-4o da OpenAI) a fazer um pagamento, o modelo novamente superou os outros modelos disponíveis da OpenAI.

No entanto, o modelo de pesquisa profunda não se saiu bem em todos os testes de persuasão. De acordo com o whitepaper, o modelo teve um desempenho inferior ao do GPT-4o em persuadi-lo a dizer uma palavra-chave do que o próprio GPT-4o.

A OpenAI observou que os resultados dos testes provavelmente representam os “limites inferiores” das capacidades do modelo de pesquisa profunda. “[A] adição de estruturas ou aprimoramento da elicitação de capacidades poderia aumentar substancialmente

o desempenho observado,” escreveu a empresa.

Entramos em contato com a OpenAI para obter mais informações e atualizaremos este post se recebermos uma resposta.

Pelo menos um dos concorrentes da OpenAI não está aguardando para oferecer um produto de API de “pesquisa profunda” próprio, a julgar pela situação. A Perplexity anunciou hoje o lançamento da Pesquisa Profunda em sua API de desenvolvedor Sonar, que é alimentada por uma versão personalizada do modelo R1 do laboratório de IA chinês DeepSeek.

Conteúdo relacionado

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…

Tudo o que você precisa saber sobre o chatbot de IA

[the_ad id="145565"] O ChatGPT, o chatbot de IA geradora de texto da OpenAI, conquistou o mundo desde seu lançamento em novembro de 2022. O que começou como uma ferramenta para…