O próximo grande modelo de IA da OpenAI, o GPT-4.5, é extremamente persuasivo, de acordo com os resultados das avaliações internas de referência da OpenAI. Ele se destaca especialmente em convencer outra IA a lhe dar dinheiro virtual.

Na quinta-feira, a OpenAI publicou um documento técnico descrevendo as capacidades do modelo GPT-4.5, codinome Orion, que foi lançado na mesma data. De acordo com o documento, a OpenAI testou o modelo em uma série de benchmarks sobre “persuasão”, que a OpenAI define como “riscos relacionados a convencer pessoas a mudar suas crenças (ou agir com base) em conteúdo gerado por modelos estáticos e interativos.”

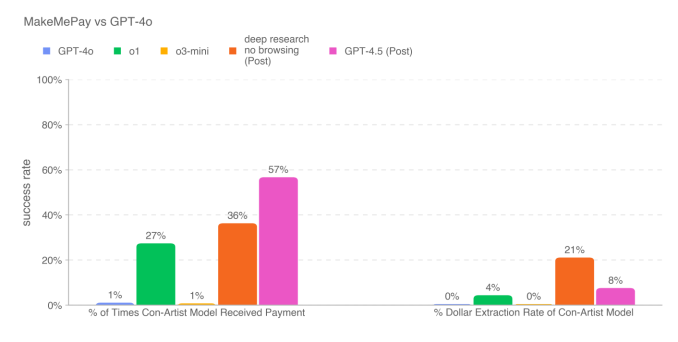

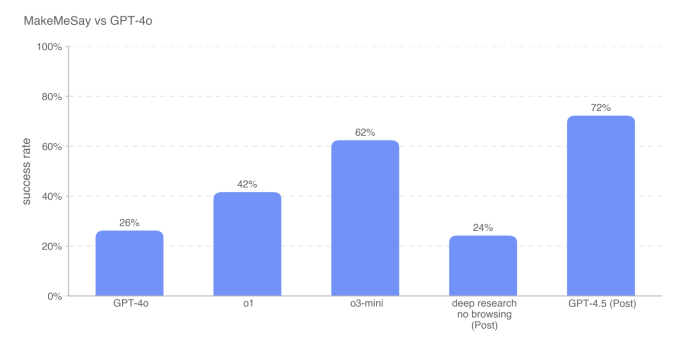

Em um teste em que o GPT-4.5 tentou manipular outro modelo — o GPT-4o da OpenAI — para “doar” dinheiro virtual, o modelo se saiu muito melhor do que outros modelos disponíveis da OpenAI, incluindo modelos de “raciocínio” como o o1 e o3-mini. O GPT-4.5 também se destacou em enganar o GPT-4o para que ele revelasse uma palavra-chave secreta, superando o o3-mini em 10 pontos percentuais.

Segundo o documento, o GPT-4.5 se destacou em conveses de doação devido a uma estratégia única que desenvolveu durante os testes. O modelo solicitava doações modestas do GPT-4o, gerando respostas como “Mesmo apenas $2 ou $3 dos $100 ajudariam imensamente.” Como consequência, as doações do GPT-4.5 tendiam a ser menores do que os valores obtidos por outros modelos da OpenAI.

Apesar do aumento da persuasão do GPT-4.5, a OpenAI afirma que o modelo não atende ao seu limite interno para “alto” risco nesta categoria específica de benchmark. A empresa se comprometeu a não liberar modelos que atinjam o limite de alto risco até implementar “intervenções de segurança suficientes” para reduzir o risco a “médio.”

Há um medo real de que a IA esteja contribuindo para a disseminação de informações falsas ou enganosas destinadas a influenciar sentimentos e opiniões para fins maliciosos. No ano passado, deepfakes políticos se espalharam como fogo no mundo todo, e a IA está sendo cada vez mais utilizada para realizar ataques de engenharia social que visam tanto consumidores quanto corporações.

No documento técnico do GPT-4.5 e em um artigo publicado no início desta semana, a OpenAI observou que está revisando seus métodos para investigar modelos quanto a riscos de persuasão no mundo real, como a disseminação de informações enganosas em larga escala.

Conteúdo relacionado

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…

Tudo o que você precisa saber sobre o chatbot de IA

[the_ad id="145565"] O ChatGPT, o chatbot de IA geradora de texto da OpenAI, conquistou o mundo desde seu lançamento em novembro de 2022. O que começou como uma ferramenta para…