Participe de nossas newsletters diárias e semanais para obter as últimas atualizações e conteúdos exclusivos sobre a cobertura de IA de ponta. Saiba mais

Com a estreia disruptiva do DeepSeek-R1, os modelos de raciocínio têm sido muito comentados até agora em 2025.

A IBM está agora entrando nessa corrida, com o lançamento hoje de sua família de modelos de linguagem grande (LLM) Granite 3.2. Diferentemente de outras abordagens de raciocínio, como o DeepSeek-R1 ou o o3 da OpenAI, a IBM está integrando profundamente o raciocínio em seus modelos Granito de código aberto. Essa abordagem é chamada de raciocínio condicional, onde o raciocínio em cadeia (CoT) é uma opção dentro dos modelos (e não um modelo separado).

É uma abordagem flexível onde o raciocínio pode ser ativado condicionalmente com um sinalizador, permitindo que os usuários controlem quando utilizar um processamento mais intenso. A nova capacidade de raciocínio constrói sobre os ganhos de desempenho que a IBM introduziu com o lançamento dos LLMs Granite 3.1 em dezembro de 2024.

A IBM também está lançando um novo modelo de visão na família Granite 3.2 que é especificamente otimizado para processamento de documentos. O modelo é particularmente útil para digitalizar documentos legados, um desafio com o qual muitas grandes organizações lutam.

Outro desafio de IA corporativa que a IBM pretende resolver com o Granite 3.2 é a modelagem preditiva. A aprendizagem de máquina (ML) tem sido usada para previsões há décadas, mas não tinha a interface de linguagem natural e a facilidade de uso da moderna IA generativa. É aí que os modelos de previsão de séries temporais da IBM entram; eles aplicam tecnologia de transformador para prever valores futuros a partir de dados temporais.

“Raciocínio não é algo que um modelo é, é algo que um modelo faz”, disse David Cox, VP de modelos de IA na IBM Research, ao VentureBeat.

O que o raciocínio da IBM realmente traz para a IA corporativa

Embora não tenha faltado empolgação e hype em torno dos modelos de raciocínio em 2025, raciocinar por si só não necessariamente fornece valor para os usuários empresariais.

A capacidade de raciocinar, em muitos aspectos, já foi parte da IA generativa. Basta solicitar a um LLM que responda de forma passo a passo para ativar uma saída básica de raciocínio CoT. O raciocínio moderno em modelos como o DeepSeek-R1 e agora o Granite 3.2 vai um pouco mais fundo, utilizando aprendizagem por reforço para treinar e habilitar capacidades de raciocínio.

Enquanto os prompts CoT podem ser eficazes para certas tarefas, como matemática, as capacidades de raciocínio no Granite 3.2 podem beneficiar uma gama mais ampla de aplicações empresariais. Cox observou que, ao encorajar o modelo a passar mais tempo pensando, as empresas podem melhorar processos complexos de tomada de decisão. O raciocínio pode beneficiar tarefas de engenharia de software, resolução de problemas de TI e outros fluxos de trabalho onde o modelo pode decompor problemas, fazer julgamentos melhores e recomendar soluções mais informadas.

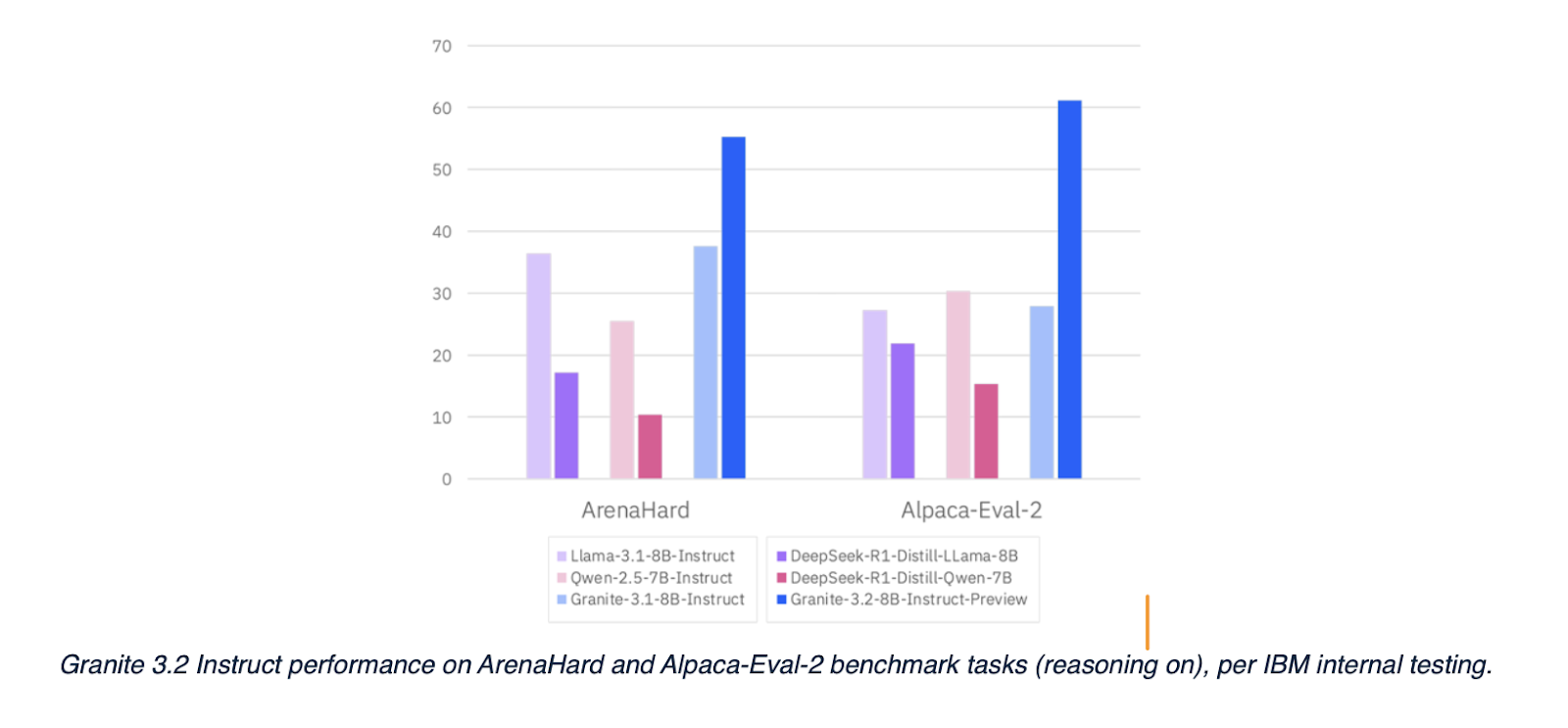

A IBM também afirma que, com o raciocínio ativado, o Granite 3.2 é capaz de superar rivais, incluindo o DeepSeek-R1, em tarefas de seguimento de instruções.

Nem toda consulta precisa de mais raciocínio; a importância do pensamento condicional

Embora o Granite 3.2 tenha capacidades avançadas de raciocínio, Cox enfatizou que nem toda consulta realmente precisa de mais raciocínio. Na verdade, muitos tipos de consultas comuns podem ser negativamente impactadas por mais raciocínio.

Por exemplo, para uma consulta baseada em conhecimento, um modelo de raciocínio independente como o DeepSeek-R1 poderia gastar até 50 segundos em um monólogo interno para responder a uma pergunta básica como “Onde fica Roma?”.

Uma das principais inovações no Granite 3.2 é a introdução de um recurso de pensamento condicional, que permite que desenvolvedores ativem ou desativem dinamicamente as capacidades de raciocínio do modelo. Essa flexibilidade possibilita que os usuários encontrem um equilíbrio entre velocidade e profundidade de análise, dependendo da tarefa específica em questão.

Avançando um passo além, os modelos Granite 3.2 se beneficiam de um método desenvolvido pela unidade de negócios Red Hat da IBM, que utiliza algo chamado “filtro de partículas” para habilitar capacidades de raciocínio mais flexíveis.

Essa abordagem permite que o modelo controle e gerencie várias linhas de raciocínio simultaneamente, avaliando quais são as mais promissoras para chegar ao resultado final. Isso proporciona um processo de raciocínio mais dinâmico e adaptável, ao invés de um CoT linear. Cox explicou que essa técnica de filtro de partículas oferece ainda mais flexibilidade para as empresas sobre como usar as capacidades de raciocínio do modelo.

No método de filtro de partículas, muitas linhas de raciocínio ocorrem simultaneamente. O filtro de partículas poda as abordagens menos eficazes, focando nas que oferecem melhores resultados. Assim, em vez de fazer apenas raciocínio CoT, há várias abordagens para resolver um problema. O modelo pode navegar inteligentemente por problemas complexos, concentrando-se seletivamente nas linhas de raciocínio mais promissoras.

Como a IBM está resolvendo casos de uso reais para documentos empresariais

Grandes organizações tendem a ter volumes igualmente grandes de documentos, muitos dos quais foram digitalizados há anos e agora estão armazenados em arquivos. Todos esses dados têm sido difíceis de usar com sistemas modernos.

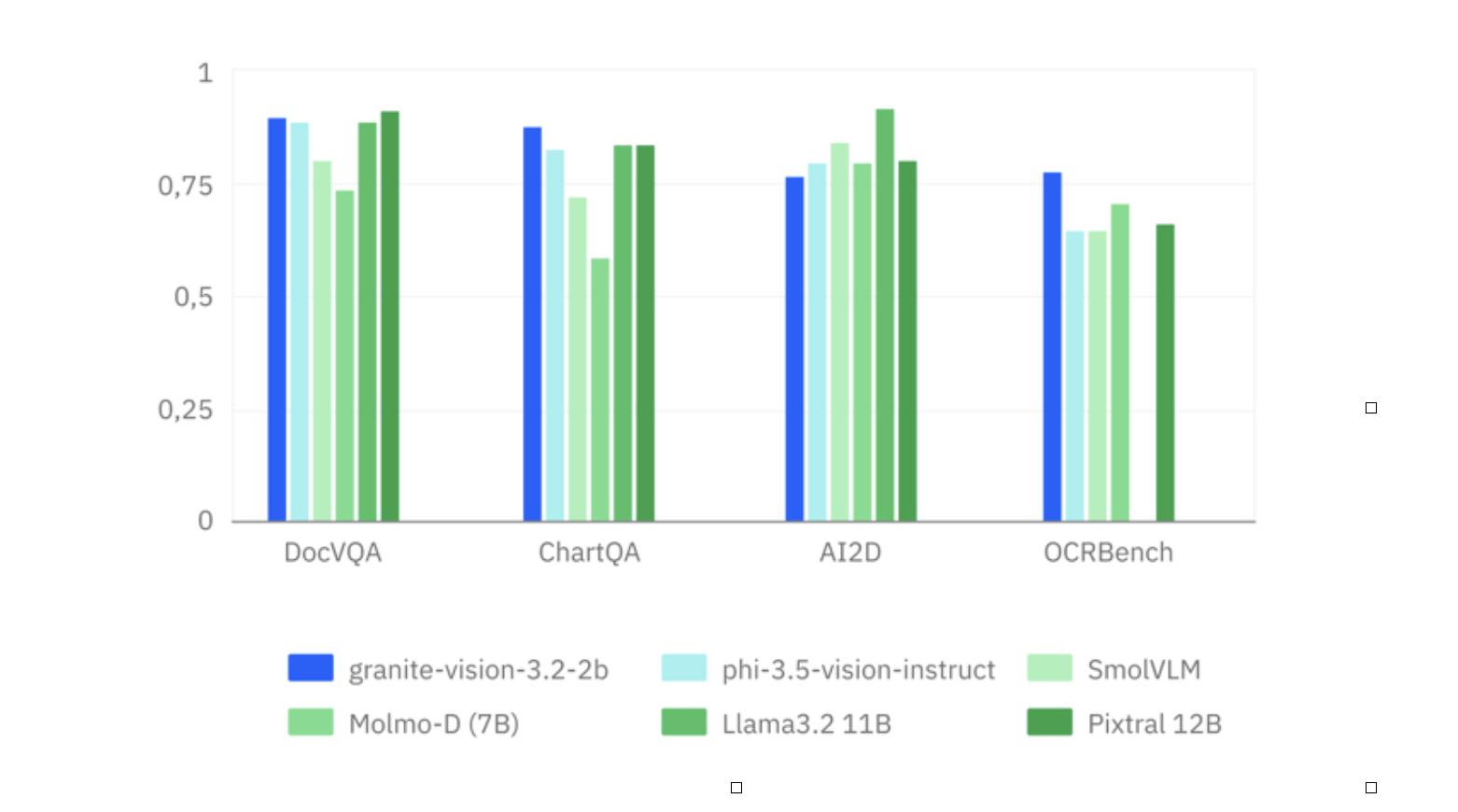

O novo modelo de visão Granite 3.2 é projetado para ajudar a resolver esse desafio corporativo. Enquanto muitos modelos multimodais se concentram na compreensão de imagens em geral, as capacidades de visão do Granite 3.2 são desenvolvidas especificamente para o processamento de documentos — refletindo o foco da IBM em resolver problemas tangíveis do empresariais em vez de perseguir notas de benchmark.

O sistema visa o que Cox descreveu como “quantidades irracionais de antigos documentos digitalizados” armazenados em arquivos empresariais, particularmente em instituições financeiras. Esses representam depósitos de dados opacos que permaneceram em grande parte inexplorados, apesar do seu potencial de valor comercial.

Para organizações com décadas de registros em papel, a capacidade de processar documentos contendo gráficos, figuras e tabelas de maneira inteligente representa uma vantagem operacional substancial em relação a modelos multimodais de uso geral que se destacam em descrever fotos de férias, mas têm dificuldades com documentos empresariais estruturados.

Em benchmarks empresariais como DocVQA e ChartQA, o IBM Granite vision 3.2 apresenta fortes resultados em comparação com rivais.

A previsão de séries temporais atende às necessidades críticas de predição empresarial

Talvez o componente tecnicamente mais distinto do lançamento seja os “tiny time mixers” (TTM) da IBM – modelos baseados em transformadores especializados, projetados especificamente para previsão de séries temporais.

No entanto, a previsão de séries temporais, que habilita análises preditivas e modelagem, não é nova. Cox observou que, por várias razões, os modelos de séries temporais têm permanecido presos na era mais antiga de machine learning (ML) e não beneficiaram da mesma atenção que os novos e chamativos modelos de IA generativa.

Os modelos Granite TTM aplicam as inovações arquitetônicas que impulsionaram os avanços dos LLM a um domínio completamente diferente: prever valores futuros com base em padrões históricos. Essa capacidade atende a necessidades empresariais críticas em áreas como previsão financeira, programação de manutenção de equipamentos e detecção de anomalias.

Adotando uma abordagem prática e focada no empresariado para a IA generativa

Não falta hype e os fornecedores estão todos afirmando superar uns aos outros em uma infinidade de benchmarks do setor.

Para os tomadores de decisão no setor empresarial, notar os benchmarks pode ser interessante, mas isso não resolve os problemas. Cox enfatizou que a IBM está adotando uma abordagem de “terno e gravata” para a IA corporativa, buscando resolver problemas reais.

“Acho que há muito pensamento mágico acontecendo em que podemos ter um modelo super inteligente que de alguma forma fará tudo o que precisamos, e, pelo menos por enquanto, não estamos nem perto disso”, disse Cox. “Nossa estratégia é ‘Vamos construir ferramentas reais e práticas usando essa tecnologia muito empolgante, e vamos incorporar o maior número possível de recursos que facilitam a realização de trabalhos reais.’

Insights diários sobre casos de uso empresarial com o VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo o que você precisa. Nós te damos o scoop sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implementações práticas, para que você possa compartilhar insights para um ROI máximo.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais newsletters do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Pesquisador de IA renomado lança startup polêmica para substituir todos os trabalhadores humanos em todos os lugares

[the_ad id="145565"] De vez em quando, uma startup do Vale do Silício lança uma missão tão “absurdamente” descrita que é difícil discernir se a startup é real ou apenas uma…

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…