Inscreva-se em nossas newsletters diárias e semanais para receber as últimas atualizações e conteúdos exclusivos sobre a cobertura de IA líder do setor. Saiba Mais

Cerebras Systems, uma startup de hardware de IA que tem desafiado consistentemente o domínio da Nvidia no mercado de inteligência artificial, anunciou na terça-feira uma expansão significativa de sua presença em data centers e duas grandes parcerias empresariais que posicionam a empresa para se tornar o principal fornecedor de serviços de inferência de IA em alta velocidade.

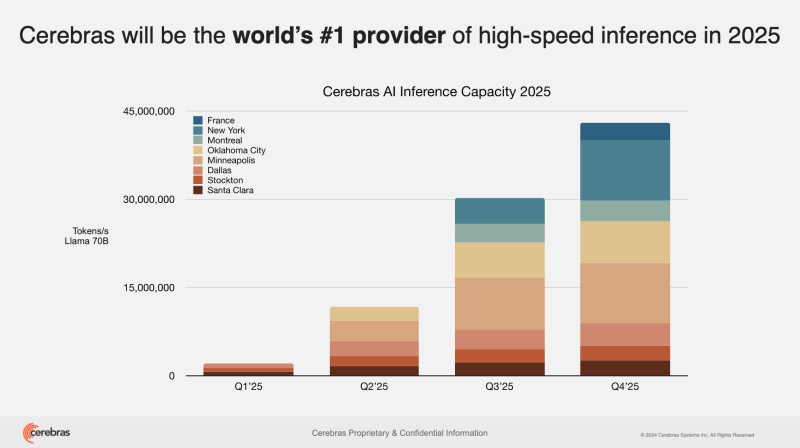

A empresa adicionará seis novos data centers de IA na América do Norte e na Europa, aumentando sua capacidade de inferência em vinte vezes, para mais de 40 milhões de tokens por segundo. A expansão inclui instalações em Dallas, Minneapolis, Oklahoma City, Montreal, Nova York e França, com 85% da capacidade total localizada nos Estados Unidos.

“Este ano, nosso objetivo é realmente satisfazer toda a demanda e a nova demanda que esperamos que surgirá como resultado de novos modelos como Llama 4 e novos modelos DeepSeek”, disse James Wang, Diretor de Marketing de Produto da Cerebras, em uma entrevista ao VentureBeat. “Esta é nossa grande iniciativa de crescimento este ano para satisfazer a demanda praticamente ilimitada que estamos vendo em várias frentes por tokens de inferência.”

A expansão dos data centers representa a aposta ambiciosa da empresa de que o mercado para inferência de IA em alta velocidade — o processo em que modelos de IA treinados geram saídas para aplicações do mundo real — crescerá dramaticamente à medida que as empresas buscam alternativas mais rápidas às soluções baseadas em GPU da Nvidia.

Parcerias estratégicas que trazem IA em alta velocidade para desenvolvedores e analistas financeiros

Junto com a expansão da infraestrutura, a Cerebras anunciou parcerias com Hugging Face, a popular plataforma de desenvolvimento de IA, e AlphaSense, uma plataforma de inteligência de mercado amplamente utilizada na indústria de serviços financeiros.

A integração com Hugging Face permitirá que seus cinco milhões de desenvolvedores acessem Cerebras Inference com um único clique, sem precisar se inscrever separadamente na Cerebras. Isso representa um importante canal de distribuição para a Cerebras, particularmente para desenvolvedores que trabalham com modelos de código aberto como Llama 3.3 70B.

“Hugging Face é meio que o GitHub da IA e o centro de todo o desenvolvimento de IA de código aberto,” explicou Wang. “A integração é muito boa e nativa. Você só aparece na lista de provedores de inferência deles. Você apenas marca a caixa e então pode usar a Cerebras imediatamente.”

A parceria com a AlphaSense representa uma significativa conquista de cliente empresarial, com a plataforma de inteligência financeira mudando de um “fornecedor de modelo de IA fechado de classe global, top 3” para a Cerebras. A empresa, que atende aproximadamente 85% das empresas da Fortune 100, está usando a Cerebras para acelerar suas capacidades de busca potencializadas por IA para inteligência de mercado.

“Esta é uma grande vitória de cliente e um contrato muito significativo para nós,” disse Wang. “Nós os aceleramos em 10 vezes, então o que antes levava cinco segundos ou mais basicamente se tornou instantâneo na Cerebras.”

Como a Cerebras está ganhando a corrida por velocidade de inferência de IA à medida que modelos de raciocínio diminuem

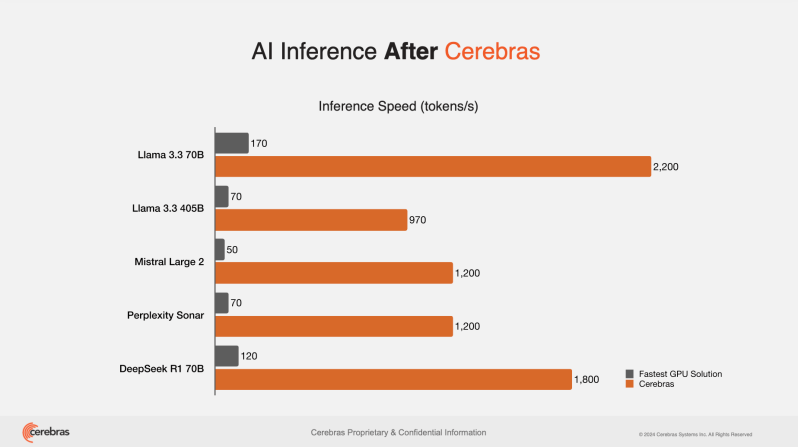

A Cerebras tem se posicionado como um especialista em inferência em alta velocidade, alegando que seu processador Wafer-Scale Engine (WSE-3) pode executar modelos de IA de 10 a 70 vezes mais rápido que soluções baseadas em GPU. Essa vantagem de velocidade se tornou cada vez mais valiosa à medida que os modelos de IA evoluem para capacidades de raciocínio mais complexas.

“Se você ouvir os comentários de Jensen, raciocínio é a próxima grande coisa, mesmo segundo a Nvidia,” disse Wang, referindo-se ao CEO da Nvidia, Jensen Huang. “Mas o que ele não está te dizendo é que raciocínio faz tudo funcionar 10 vezes mais devagar porque o modelo precisa pensar e gerar uma série de monólogos internos antes de dar a resposta final.”

Essa desaceleração cria uma oportunidade para a Cerebras, cujo hardware especializado é projetado para acelerar essas cargas de trabalho de IA mais complexas. A empresa já garantiu clientes de destaque, incluindo Perplexity AI e Mistral AI, que utilizam a Cerebras para alimentar seus produtos de busca e assistente de IA, respectivamente.

“Ajudamos a Perplexity a se tornar o motor de busca de IA mais rápido do mundo. Isso simplesmente não seria possível de outra forma,” disse Wang. “Ajudamos a Mistral a atingir a mesma façanha. Agora eles têm um motivo para as pessoas se inscreverem no Le Chat Pro, enquanto antes, seu modelo provavelmente não estava no mesmo nível de ponta que o GPT-4.”

A economia interessante por trás do desafio da Cerebras à OpenAI e Nvidia

A Cerebras acredita que a combinação de velocidade e custo tornará seus serviços de inferência atraentes até mesmo para empresas que já utilizam modelos líderes como o GPT-4.

Wang destacou que o modelo Llama 3.3 70B da Meta, um modelo de código aberto que a Cerebras otimizou para seu hardware, agora pontua o mesmo em testes de inteligência que o GPT-4 da OpenAI, enquanto custa significativamente menos para operar.

“Qualquer um que esteja usando o GPT-4 hoje pode simplesmente mudar para o Llama 3.3 70B como um substituto direto,” explicou. “O preço do GPT-4 é [cerca de] $4,40 em termos mistos. E o Llama 3.3 custa cerca de 60 centavos. Estamos em torno de 60 centavos, certo? Portanto, você reduz o custo em quase uma ordem de magnitude. E se você usar a Cerebras, aumentará a velocidade em outra ordem de magnitude.”

Dentro dos data centers tornado-proof da Cerebras construídos para resiliência em IA

A empresa está fazendo investimentos substanciais em infraestrutura resiliente como parte de sua expansão. Sua instalação em Oklahoma City, programada para entrar em operação em junho de 2025, foi projetada para suportar eventos climáticos extremos.

“Oklahoma, como você sabe, é uma espécie de zona de tornados. Portanto, este data center é classificado e projetado para ser totalmente resistente a tornados e atividades sísmicas,” disse Wang. “Ele suportará o tornado mais forte já registrado. Se aquele passar, ele continuará enviando tokens Llama para os desenvolvedores.”

A instalação de Oklahoma City, operada em parceria com o Scale Datacenter, abrigará mais de 300 sistemas Cerebras CS-3 e conta com estações de energia triplo redundantes e soluções de resfriamento personalizadas especificamente projetadas para os sistemas em wafer da Cerebras.

Do ceticismo à liderança de mercado: Como a Cerebras está provando seu valor

A expansão e as parcerias anunciadas hoje representam um marco significativo para a Cerebras, que tem trabalhado para se afirmar em um mercado de hardware de IA dominado pela Nvidia.

“Acho que o que era um ceticismo razoável sobre a adoção dos clientes, talvez quando lançamos pela primeira vez, agora está totalmente dissipado, dado a diversidade de logos que temos,” disse Wang.

A empresa está direcionando suas atenções para três áreas específicas onde a inferência rápida oferece mais valor: processamento em tempo real de voz e vídeo, modelos de raciocínio e aplicações de codificação.

“Codificação é uma dessas áreas intermediárias entre raciocínio e Q&A regular que leva talvez 30 segundos a um minuto para gerar todo o código,” explicou Wang. “A velocidade está diretamente proporcional à produtividade do desenvolvedor. Portanto, ter velocidade lá é importante.”

Ao se concentrar em inferências de alta velocidade em vez de competir em todas as cargas de trabalho de IA, a Cerebras encontrou um nicho onde pode reivindicar liderança sobre até mesmo os maiores provedores de nuvem.

“Ninguém geralmente compete contra AWS e Azure em sua escala. Nós, obviamente, não alcançamos toda a escala como eles, mas para conseguir replicar um segmento chave… na frente de inferência em alta velocidade, teremos mais capacidade do que eles,” disse Wang.

Por que a expansão centrada nos EUA da Cerebras importa para a soberania em IA e cargas de trabalho futuras

A expansão ocorre em um momento em que a indústria de IA está cada vez mais focada nas capacidades de inferência, à medida que as empresas passam de experimentação com IA generativa para sua implantação em aplicações de produção onde velocidade e eficiência de custo são críticas.

Com 85% da sua capacidade de inferência localizada nos Estados Unidos, a Cerebras também está se posicionando como um jogador chave no avanço da infraestrutura doméstica em IA em um momento em que a soberania tecnológica se tornou uma prioridade nacional.

“A Cerebras está turboalimentando o futuro da liderança dos EUA em IA com desempenho, escala e eficiência inigualáveis – esses novos data centers globais servirão como a espinha dorsal para a próxima onda de inovação em IA,” disse Dhiraj Mallick, COO da Cerebras Systems, no anúncio da empresa.

À medida que modelos de raciocínio como DeepSeek R1 e o3 da OpenAI se tornem mais prevalentes, a demanda por soluções de inferência mais rápidas provavelmente crescerá. Esses modelos, que podem levar minutos para gerar respostas em hardware tradicional, operam praticamente instantaneamente nos sistemas Cerebras, segundo a empresa.

Para decisores técnicos que estão avaliando opções de infraestrutura de IA, a expansão da Cerebras representa uma nova alternativa significativa às soluções baseadas em GPU, especialmente para aplicações em que o tempo de resposta é crítico para a experiência do usuário.

Se a empresa conseguirá realmente desafiar o domínio da Nvidia no mercado de hardware de IA mais amplo ainda está por ser visto, mas seu foco em inferência de alta velocidade e investimento substancial em infraestrutura demonstram uma estratégia clara para conquistar um segmento valioso do rapidamente evolutivo cenário de IA.

Insights diários sobre casos de uso de negócios com o VB Daily

Se você quiser impressionar seu chefe, o VB Daily tem tudo o que você precisa. Oferecemos a você a scoop sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implementações práticas, para que você possa compartilhar insights para um ROI máximo.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais newsletters do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Por que a Onyx acredita que sua solução de código aberto vencerá a busca empresarial

[the_ad id="145565"] As empresas possuem uma enorme quantidade de dados e informações internas que os funcionários precisam para realizar suas tarefas ou responder perguntas de…

Nunu.ai levanta US$ 6 milhões para agentes de IA chamados ‘mentes não incorporadas’ para testes de jogos

[the_ad id="145565"] Nunu.ai arrecadou $6 milhões e apresentou os Mentes Não Encarnadas, ou agentes de IA projetados para testes de jogos e para controlar qualquer corpo dado e…

Meta está supostamente testando chips desenvolvidos internamente para treinamento de IA.

[the_ad id="145565"] A Meta está supostamente testando um chip interno para treinamento de sistemas de IA, parte de uma estratégia para reduzir sua dependência de fabricantes…