Kazu Gomi possui uma ampla visão do mundo da tecnologia a partir de seu posto no Vale do Silício. Como presidente e CEO da NTT Research, uma divisão da grande empresa de telecomunicações japonesa NTT, Gomi pode controlar o orçamento de P&D para uma parte considerável das pesquisas básicas realizadas no Vale do Silício.

E, talvez, não seja surpresa que Gomi esteja investindo bastante em IA para o setor empresarial, buscando novas oportunidades para aproveitar a explosão da IA. Na semana passada, Gomi apresentou um novo esforço de pesquisa focado na física da IA, além de um projeto de design de chip para um chip de inferência de IA que pode processar vídeo 4K mais rapidamente. Isso ocorre na esteira de projetos de pesquisa anunciados no ano passado que podem abrir caminho para uma IA melhor e data centers mais eficientes em termos de energia.

Conversei com Gomi sobre esse esforço no contexto de outras iniciativas que grandes empresas como a Nvidia estão realizando. A IA física se tornou um grande tema em 2025, com a Nvidia liderando a criação de dados sintéticos para pré-testar carros autônomos e robótica humanoide, permitindo que cheguem ao mercado mais rapidamente.

Construindo sobre uma história que primeiramente fiz em meu primeiro emprego como repórter de tecnologia, Gomi disse que a empresa está pesquisando computação fotônica como uma maneira de tornar a computação de IA muito mais eficiente em termos de energia.

Décadas atrás, fiz uma visita à Bell Labs e ouvi as ambições de Alan Huang enquanto ele buscava criar um computador óptico. A equipe de Gomi está tentando fazer algo semelhante décadas depois. Se conseguirem, isso poderá fazer os data centers operarem com muito menos energia, uma vez que a luz não colide com outras partículas ou gera atrito da mesma forma que os sinais elétricos.

Durante o evento da semana passada, tive prazer em conversar com um pequeno robô de mesa chamado Jibo que girava e “dançava”, me dizendo meus sinais vitais, como meu batimento cardíaco, nível de oxigênio no sangue, pressão arterial e até meu colesterol — tudo por meio de um scanner da pele que observava pequenas palpitações e mudanças de cor à medida que o sangue se movia pelas minhas bochechas. Ele também manteve uma conversa comigo através de sua capacidade de chat com IA.

A NTT tem mais de 330.000 funcionários e uma receita anual de $97 bilhões. A NTT Research é parte da NTT, uma provedora global de tecnologia e soluções empresariais com um orçamento anual de P&D de $3,6 bilhões. Há cerca de seis anos, criaram uma divisão de P&D no Vale do Silício.

Aqui está uma transcrição editada de nossa entrevista.

VentureBeat: Você sente que há um tema, um tema predominante este ano em relação ao que você discutiu no ano passado?

Kazu Gomi: Não é segredo. Estamos mais focados em IA. A IA está no centro. Também falamos sobre IA no ano passado, mas hoje é mais evidente.

VentureBeat: Eu queria saber sua opinião sobre o que eu absorvi na CES, quando Jensen Huang apresentou seu discurso. Ele falou muito sobre dados sintéticos e como isso aceleraria a IA física. Porque você pode testar seus carros autônomos com dados sintéticos, ou testar robôs humanoides, assim muito mais testes podem ser realizados de maneira confiável no domínio virtual. Eles chegam ao mercado muito mais rápido. Você acha que isso faz sentido, que dados sintéticos podem levar a essa aceleração?

Gomi: Para os robôs, sim, 100%. Para os robôs e todas as coisas físicas, faz total sentido. A IA está influenciando muitas outras coisas também. Provavelmente não tudo. Dados sintéticos não podem mudar tudo. Mas a IA está impactando a forma como as corporações se administram. O departamento jurídico pode ser substituído por IA. O departamento de RH pode ser substituído por IA. Nesses casos, não estou certo de como dados sintéticos fazem diferença. Não têm tanto impacto quanto teria em coisas como carros autônomos.

VentureBeat: Isso me fez pensar que tudo vai acontecer tão rápido, como robôs humanoides e carros autônomos, que teremos que decidir se realmente os queremos e para quê os queremos.

Gomi: Essa é uma grande questão. Como você lida com eles? Nós definitivamente começamos a conversar sobre isso. Como você trabalha com eles?

VentureBeat: Como você os usa para complementar os trabalhadores humanos, mas também — eu acho que uma de suas pessoas falou sobre elevar o padrão de vida [para humanos, e não para robôs].

Gomi: Certo. Se você fizer isso da maneira certa, absolutamente. Há muitas boas maneiras de trabalhar com eles. Certamente também há cenários ruins que são possíveis.

VentureBeat: Se vimos essa aceleração toda no último ano ou mais, e podemos esperar que dados sintéticos acelerem ainda mais, o que você espera que aconteça daqui a dois anos?

Gomi: Não exatamente sobre dados sintéticos em si, mas hoje, um dos comunicados de imprensa que minha equipe lançou é sobre nosso novo grupo de pesquisa, chamado Física da IA. Estou ansioso pelos resultados que virão desse time, de tantas maneiras diferentes. Uma das interessantes é que — essa coisa humanoide se aproxima disso. Mas agora não sabemos — tratamos a IA como uma caixa preta. Não sabemos exatamente o que está acontecendo dentro da caixa. Esse é um problema. Essa equipe está olhando dentro da caixa preta.

Existem muitos benefícios potenciais, mas um deles é intuitivo: se a IA começar a dizer algo errado, algo tendencioso, obviamente você precisa fazer correções. Atualmente, não temos uma maneira muito boa e eficaz de corrigir isso, exceto continuar dizendo: “Isto está errado, você deveria dizer isso ao invés daquilo.” Há pesquisas dizendo que apenas os dados não nos salvarão.

VentureBeat: Parece que você está tentando ensinar algo a um bebê?

Gomi: Sim, exatamente. O cenário ideal interessante — com essa Física da IA, efetivamente o que podemos fazer é um mapeamento do conhecimento. No final, a IA é um programa de computador. É composta por conexões neurais, bilhões de neurônios interconectados. Se há viés, vem de uma conexão particular entre neurônios. Se pudermos encontrar isso, podemos, em última análise, reduzir o viés ao cortar essas conexões. Esse é o melhor cenário. Todos sabemos que as coisas não são tão simples. Mas a equipe pode ser capaz de informar que, se você cortar esses neurônios, poderá reduzir o viés 80% do tempo, ou 60%. Eu espero que essa equipe alcance algo assim. Mesmo 10% ainda é bom.

VentureBeat: O chip de inferência de IA. Você está tentando superar a Nvidia? Parece que seria muito difícil.

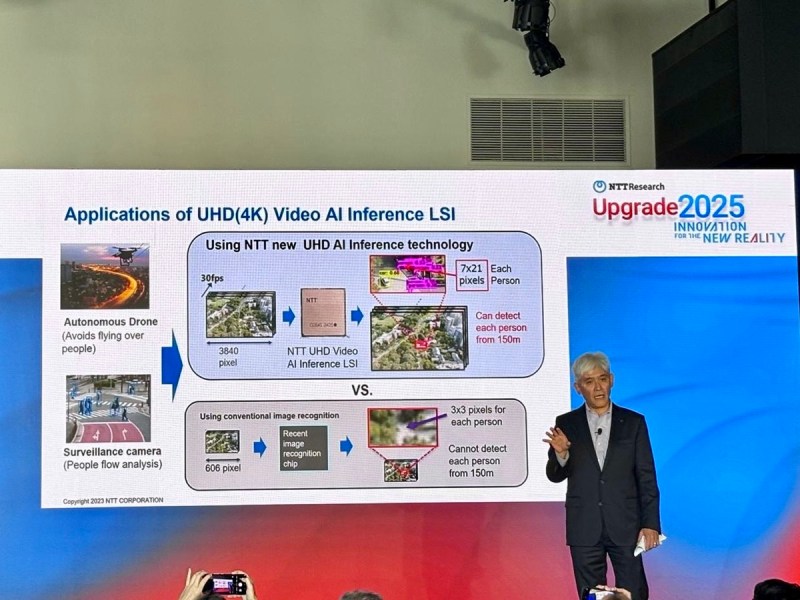

Gomi: Com esse projeto em particular, não, não é isso que estamos fazendo. E sim, é muito difícil de fazer. Comparar esse chip com a Nvidia é como comparar maçãs com laranjas. O GPU da Nvidia é mais um chip de IA de propósito geral. Ele pode alimentar chat bots ou carros autônomos. Você pode fazer todo tipo de IA com ele. Este que liberamos ontem é bom apenas para vídeos e imagens, detecção de objetos e assim por diante. Você não vai criar um chat bot com ele.

VentureBeat: Parece que havia uma oportunidade a ser aproveitada? Algo não estava funcionando bem nessa área?

Gomi: A resposta curta é sim. Novamente, esse chip é definitivamente personalizado para processamento de vídeo e imagem. A chave é que, sem reduzir a resolução da imagem base, podemos fazer inferência. Imagens de alta resolução, 4K, podem ser usadas para inferência. O benefício é que — pegue o caso de uma câmera de vigilância. Talvez ela esteja a 500 metros do objeto que você deseja observar. Com vídeo 4K, você pode ver bem o objeto. Mas, com a tecnologia convencional, devido ao poder de processamento, você tem que reduzir a resolução. Talvez você conseguisse identificar que se tratava de uma garrafa, mas não conseguiria ler nada nela. Talvez você pudesse ampliar, mas então perderia outras informações da área ao redor. Você pode fazer mais com essa câmera de vigilância usando essa tecnologia. A maior resolução é o benefício.

VentureBeat: Isso pode não estar relacionado, mas estou interessado nos chips gráficos da Nvidia, onde estavam usando DLSS, utilizando IA para prever o próximo pixel que você precisa desenhar. Essa previsão funciona tão bem que obteve oito vezes mais rapidez nesta geração. O desempenho geral agora é algo como — de 30 quadros, a IA pode prever com precisão 29 deles. Você está fazendo algo semelhante aqui?

Gomi: Algo relacionado a isso — a razão pela qual estamos trabalhando nisso é que tivemos um projeto que é o precursor dessa tecnologia. Gastamos muita energia e recursos no passado em tecnologias de codec de vídeo. Vendemos um decodificador MPEG inicial para profissionais, para câmeras de qualidade de estúdio e coisas assim. Tínhamos essa tecnologia básica. Dentro dessa tecnologia básica, algo semelhante ao que você está discutindo — há um pouco de reconhecimento de objetos ocorrendo no MPEG atual. Entre os quadros, ele prevê que um objeto está se movendo de um quadro para o próximo em tal medida. Isso faz parte da tecnologia do codec. O reconhecimento de objetos faz isso acontecer, essas previsões. Esse algoritmo, até certo ponto, é usado neste chip de inferência.

VentureBeat: Outra coisa que Jensen estava dizendo que era interessante — tivemos uma arquitetura de computação, a computação baseada em recuperação, onde você vai a um banco de dados, busca uma resposta e volta. Enquanto a IA agora nos dá a oportunidade para a computação baseada em raciocínio. A IA descobre a resposta sem precisar passar por todos os dados. Pode dizer: “Eu sei qual é a resposta,” ao invés de recuperar a resposta. Poderia ser uma forma diferente de computação do que estamos acostumados. Você acha que isso será uma grande mudança?

Gomi: Acho que sim. Muitas pesquisas sobre IA estão sendo realizadas. O que você disse é possível porque a IA tem “conhecimento.” Porque você tem esse conhecimento, não precisa recuperar dados.

VentureBeat: Porque eu sei algo, eu não preciso ir à biblioteca e procurar em um livro.

Gomi: Exatamente. Eu sei que tal evento aconteceu em 1868, porque memorize isso. Você poderia procurar em um livro ou banco de dados, mas se você souber disso, você tem esse conhecimento. É uma parte interessante da IA. Conforme se torna mais inteligente e adquire mais conhecimentos, não precisa voltar ao banco de dados cada vez.

VentureBeat: Você tem algum projeto favorito em andamento neste momento?

Gomi: Alguns. Uma coisa que quero destacar, talvez, se eu puder escolher uma — você está olhando de perto para a Nvidia e esses jogadores. Estamos colocando muito foco na tecnologia fotônica. Estamos interessados em fotônica de algumas maneiras diferentes. Quando você olha para a infraestrutura da IA — você sabe todas as histórias. Criamos tantas clusters de GPU. Todas interconectadas. A plataforma é enorme. Exige tanta energia. Estamos ficando sem eletricidade. Estamos superaquecendo o planeta. Isso não é bom.

Queremos abordar esse problema com algumas soluções diferentes. Uma delas é usar tecnologia fotônica. Há algumas maneiras diferentes. Primeiro, onde está o gargalo na plataforma atual de IA? Durante o painel de hoje, um dos painelistas falou sobre isso. Quando você olha para GPUs, em média, 50% do tempo uma GPU está inativa. Há um transporte de dados imenso ocorrendo entre processadores e memória. A memória e essa linha de comunicação é um gargalo. A GPU está esperando que os dados sejam buscados e aguardando resultados a serem gravados na memória. Isso acontece muitas vezes.

Uma ideia é usar óptica para tornar essas linhas de comunicação muito mais rápidas. Essa é uma coisa. Ao usar óptica, torná-lo mais rápido é um benefício. Outro benefício é que, quando se trata de freqüências de clock mais rápidas, a óptica é muito mais eficiente em termos de energia. E isso envolve muitos detalhes de engenharia, mas com óptica, você pode ir mais longe. Você pode ir até aqui, ou mesmo alguns pés de distância. A configuração do rack pode ser muito mais flexível e menos densa. Os requisitos de refrigeração são facilitados.

VentureBeat: Agora você está mais como data center para data center. Aqui, estamos falando de processador para memória?

Gomi: Sim, exatamente. Essa é a evolução. Atualmente é entre data centers. A próxima fase é entre os racks, entre os servidores. Após isso, dentro do servidor, entre as placas. E então, dentro da placa, entre os chips. Eventualmente, dentro do chip, entre diferentes unidades de processamento no núcleo, o cache de memória. Essa é a evolução. A Nvidia também lançou algumas embalagens que estão em linha com esse abordagem faseada.

VentureBeat: Comecei a cobrir tecnologia em 1988, em Dallas. Fiz uma visita à Bell Labs. Na época, eles estavam fazendo pesquisa em computação fotônica. Eles fizeram muito progresso, mas ainda não está exatamente aqui, mesmo agora. Isso abrangeu toda a minha carreira cobrindo tecnologia. Qual é o desafio, ou o problema?

Gomi: O cenário que acabei de mencionar não tocou a unidade de processamento em si, ou a memória em si. Somente a conexão entre os dois componentes, tornando-a mais rápida. Obviamente, o próximo passo é devemos fazer algo com a unidade de processamento e a memória propriamente ditas.

VentureBeat: Mais como um computador óptico?

Gomi: Sim, um verdadeiro computador óptico. Estamos tentando fazer isso. O que acontece é que — parece que você tem acompanhado esse tópico por um tempo. Mas aqui está um pouco da evolução, por assim dizer. Antigamente, quando a Bell Labs ou quem quer que seja tentou criar um computador baseado em óptica, basicamente estava substituindo o computador baseado em silício de um para um, exatamente. Todos os circuitos lógicos e tudo funcionariam em óptica. Isso é difícil, e continua sendo difícil. Não acho que chegaremos lá. A fotônica de silício também não resolverá o problema.

A parte interessante é, novamente, a IA. Para a IA, você não precisa de computações muito sofisticadas. A computação de IA, o núcleo dela é relativamente simples. Tudo é uma coisa chamada multiplicação de matriz-vetor. Informação entra, há um resultado e sai. Isso é tudo que você faz. Mas você precisa fazer isso um bilhão de vezes. É por isso que fica complicado e exige muita energia e assim por diante. Agora, a beleza da fotônica é que pode fazer essa multiplicação matriz-vetor pela sua própria natureza.

VentureBeat: Envolve muitos espelhos e redirecionamento?

Gomi: Sim, simplesmente espelhando e, em seguida, interferência e todas essas coisas. Para torná-lo mais eficiente e tudo mais — na opinião de meus pesquisadores, a fotônica de silício pode ser capaz de fazer isso, mas é difícil. Você precisa envolver diferentes materiais. Isso é algo em que estamos trabalhando. Não sei se você já ouviu falar disso, mas é o niobato de lítio. Usamos niobato de lítio em vez de silício. Há uma tecnologia para transformá-lo em um filme fino. Você pode realizar essas computações e multiplicações no chip. Não requer componentes digitais. É praticamente tudo feito de forma analógica. É super rápido, super eficiente em energia. Até certo ponto, imita o que se passa dentro do cérebro humano.

Esses pesquisadores de hardware, seus objetivos — um cérebro humano funciona com cerca de 20 watts. O ChatGPT exige 30 ou 40 megawatts. Podemos usar a tecnologia fotônica para reverter drasticamente a infraestrutura atual de IA, se conseguirmos chegar lá até um computador óptico.

VentureBeat: Como você está se saindo com o gêmeo digital do coração humano?

Gomi: Fizemos um progresso bastante bom no último ano. Criamos um sistema chamado sistema de intervenção autônoma em loop fechado, ACIS. Suponha que você tenha um paciente com insuficiência cardíaca. Com esse sistema aplicado — é como dirigir de forma autônoma. Teoricamente, sem intervenção humana, você pode prescrever os medicamentos e tratamentos adequados para esse coração e trazê-lo de volta a um estado normal. Parece um pouco fantasioso, mas há um gêmeo bio-digital por trás disso. O gêmeo bio-digital pode prever com precisão o estado do coração e como uma injeção de um determinado medicamento pode afetá-lo. Pode rapidamente prever causa e efeito, decidir sobre um tratamento e seguir em frente. Simulação-wise, o sistema funciona. Temos algumas boas provas de que funcionará.

VentureBeat: Jibo, o robô no estande de saúde, quão próximo isso está de ser preciso? Eu acho que ele errou meu colesterol, mas acertou tudo o mais. O colesterol parece ser difícil. Eles estavam dizendo que isso era uma nova parte do que estavam fazendo, enquanto tudo o mais estava mais estabelecido. Se você conseguir isso com alta precisão, poderá ser transformador para a frequência com a qual as pessoas precisam ver um médico.

Gomi: Não sei muito sobre esse assunto em particular. A maneira convencional de testar isso, claro, eles têm que tirar sangue e analisá-lo. Eu estou certo de que alguém está trabalhando nisso. É uma questão de que tipo de sensor você pode criar. Com dispositivos não invasivos, já podemos ler coisas como níveis de glicose. Essa é uma tecnologia interessante. Se alguém puder fazer isso para algo como colesterol, poderíamos trazê-lo para o Jibo e seguir adiante.

GB Daily

Mantenha-se informado! Receba as últimas notícias em sua caixa de entrada diariamente

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais newsletters da VB aqui.

Ocorreu um erro.

Conteúdo relacionado

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…

Tudo o que você precisa saber sobre o chatbot de IA

[the_ad id="145565"] O ChatGPT, o chatbot de IA geradora de texto da OpenAI, conquistou o mundo desde seu lançamento em novembro de 2022. O que começou como uma ferramenta para…