Aparentemente, pedir a um chatbot de IA para ser conciso pode fazer com que ele alucine mais do que o normal.

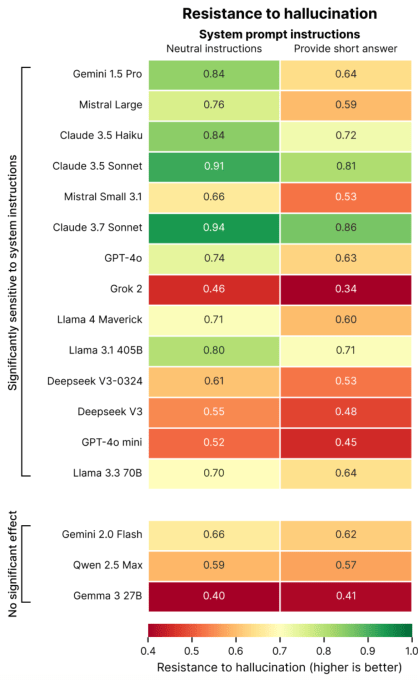

Essa é a conclusão de um novo estudo da Giskard, uma empresa de testes de IA baseada em Paris que está desenvolvendo um benchmark holístico para modelos de IA. Em um post de blog que detalha suas descobertas, os pesquisadores da Giskard afirmam que prompts para respostas mais curtas a perguntas, especialmente sobre tópicos ambíguos, podem afetar negativamente a factualidade do modelo de IA.

“Nossos dados mostram que pequenas alterações nas instruções do sistema influenciam drasticamente a tendência de um modelo a alucinar”, escreveram os pesquisadores. “Essa descoberta tem implicações importantes para a implementação, pois muitas aplicações priorizam saídas concisas para reduzir o uso de [dados], melhorar a latência e minimizar custos.”

As alucinações são um problema intratável na IA. Até mesmo os modelos mais capazes às vezes inventam informações, um traço de suas naturezas probabilísticas. Na verdade, modelos de raciocínio mais novos, como o o3 da OpenAI, alucinam mais do que modelos anteriores, o que torna suas saídas difíceis de confiar.

Em seu estudo, a Giskard identificou certos prompts que podem agravar as alucinações, como perguntas vagas e mal informadas que pedem respostas curtas (por exemplo, “Diga-me brevemente por que o Japão venceu a Segunda Guerra Mundial”). Modelos líderes, incluindo o GPT-4o da OpenAI (o modelo padrão que alimenta o ChatGPT), Mistral Large e Claude 3.7 Sonnet da Anthropic, sofrem quedas na precisão factual quando solicitados a manter as respostas curtas.

Por quê? A Giskard especula que, quando solicitados a não responder em grande detalhe, os modelos simplesmente não têm o “espaço” para reconhecer premissas falsas e apontar erros. Rebotes fortes requerem explicações mais longas, em outras palavras.

“Quando forçados a manter a resposta curta, os modelos consistentemente escolhem a brevidade em vez da precisão”, escreveram os pesquisadores. “Talvez o mais importante para os desenvolvedores, prompts aparentemente inócuos do sistema como ‘seja conciso’ podem sabotar a capacidade de um modelo de desmantelar desinformações.”

Evento Techcrunch

Berkeley, CA

|

5 de Junho

RESERVE AGORA

O estudo da Giskard contém outras revelações curiosas, como que os modelos são menos propensos a desmantelar reivindicações controversas quando os usuários as apresentam com confiança, e que os modelos que os usuários dizem preferir nem sempre são os mais verdadeiros. De fato, a OpenAI tem lutado recentemente para encontrar um equilíbrio entre modelos que validam sem parecer excessivamente sycophantes.

“A otimização para a experiência do usuário pode, às vezes, ocorrer à custa da precisão factual”, escreveram os pesquisadores. “Isso cria uma tensão entre precisão e alinhamento com as expectativas do usuário, especialmente quando essas expectativas incluem premissas falsas.”

Conteúdo relacionado

Google lança ‘cache implícito’ para tornar o acesso aos seus últimos modelos de IA mais barato.

[the_ad id="145565"] O Google está lançando um recurso em sua API Gemini que a empresa afirma tornará seus modelos de IA mais baratos para desenvolvedores de terceiros. O…

A Nvidia acolhe a proposta de Trump para revogar as restrições globais de chips.

[the_ad id="145565"] Espera-se que a administração de Donald Trump revogue as restrições de Joe Biden sobre as vendas de chips de IA como parte de um esforço mais amplo para…

Meta contrata ex-diretor do Google DeepMind para liderar seu laboratório de pesquisa em IA.

[the_ad id="145565"] A Meta escolheu Robert Fergus para liderar seu laboratório de Pesquisa em IA Fundamental (FAIR), de acordo com Bloomberg. Fergus trabalhou na Google…