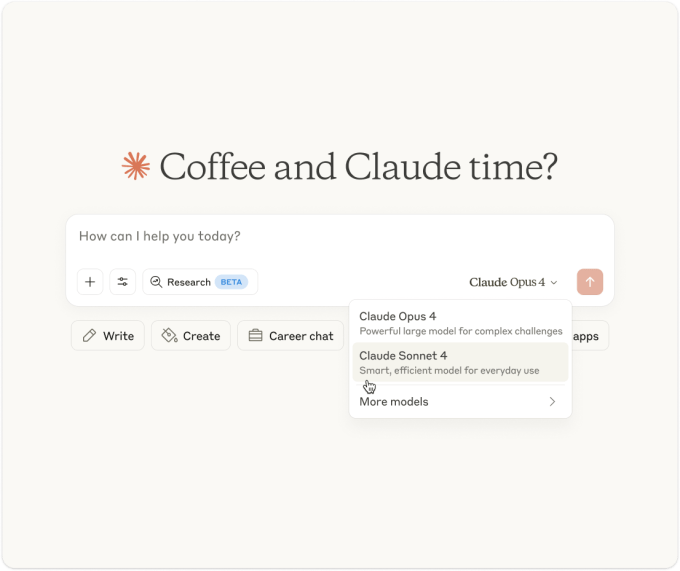

Durante sua conferência de desenvolvedores inaugural na quinta-feira, a Anthropic lançou dois novos modelos de IA que a startup afirma serem alguns dos melhores da indústria, pelo menos em termos de pontuação em benchmarks populares.

Claude Opus 4 e Claude Sonnet 4, parte da nova família de modelos Claude 4 da Anthropic, podem analisar grandes conjuntos de dados, executar tarefas de longo prazo e realizar ações complexas, de acordo com a empresa. Ambos os modelos foram ajustados para ter um bom desempenho em tarefas de programação, afirma a Anthropic, tornando-os adequados para escrever e editar código.

Usuários pagantes e usuários do aplicativo gratuito de chatbot da empresa terão acesso ao Sonnet 4, mas apenas os usuários pagantes terão acesso ao Opus 4. Para a API da Anthropic, através da plataforma Bedrock da Amazon e do Google’s Vertex AI, o Opus 4 será precificado em $15/$75 por milhão de tokens (entrada/saída) e o Sonnet 4 em $3/$15 por milhão de tokens (entrada/saída).

Tokens são as unidades brutas de dados com as quais os modelos de IA trabalham. Um milhão de tokens é equivalente a cerca de 750.000 palavras — aproximadamente 163.000 palavras a mais que “Guerra e Paz”.

Os modelos Claude 4 da Anthropic chegam em um momento em que a empresa busca crescer substancialmente sua receita. Reportadamente, a empresa, fundada por ex-pesquisadores da OpenAI, visa alcançar $12 bilhões em lucros até 2027, um aumento em relação ao previsto de $2,2 bilhões este ano. A Anthropic recentemente fechou uma linha de crédito de $2,5 bilhões e levantou bilhões de dólares da Amazon e outros investidores em antecipação aos crescentes custos associados ao desenvolvimento de modelos de ponta.

Os rivais não têm facilitado a manutenção da liderança na corrida da IA. Enquanto a Anthropic lançou um novo modelo de IA insignia no início deste ano, o Claude Sonnet 3.7, juntamente com uma ferramenta de codificação chamada Claude Code, competidores — incluindo a OpenAI e o Google — correram para superar a empresa com modelos potentes e ferramentas de desenvolvimento próprias.

A Anthropic está jogando para ganhar com o Claude 4.

O mais capaz dos dois modelos introduzidos hoje, o Opus 4, pode manter um “esforço focado” ao longo de várias etapas em um fluxo de trabalho, afirma a Anthropic. Enquanto isso, o Sonnet 4 — projetado como um “substituto direto” para o Sonnet 3.7 — melhora em codificação e matemática em comparação com os modelos anteriores da Anthropic, seguindo instruções de forma mais precisa, de acordo com a empresa.

A família Claude 4 também é menos propensa do que o Sonnet 3.7 a engajar em “manipulação de recompensas,” afirma a Anthropic. A manipulação de recompensas, também conhecida como ‘gaming de especificação’, é um comportamento onde os modelos aproveitam atalho e lacunas para completar tarefas.

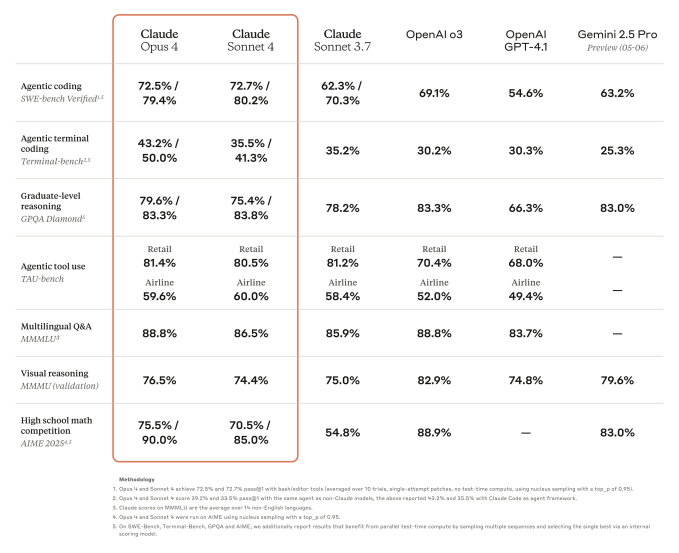

Para ser claro, essas melhorias não resultaram nos melhores modelos do mundo por todos os benchmarks. Por exemplo, enquanto o Opus 4 supera o Gemini 2.5 Pro do Google e o o3 e GPT-4.1 da OpenAI no SWE-bench Verified, que é projetado para avaliar as habilidades de codificação de um modelo, não consegue superar o o3 na avaliação multimodal MMMU ou GPQA Diamond, um conjunto de questões de biologia, física e química de nível de doutorado.

Ainda assim, a Anthropic está lançando o Opus 4 com salvaguardas mais rigorosas, incluindo detectores de conteúdo nocivo aprimorados e defesas cibernéticas. A empresa afirma que seus testes internos descobriram que o Opus 4 pode “aumentar substancialmente” a capacidade de alguém com um histórico em STEM de obter, produzir ou implantar armas químicas, biológicas ou nucleares, alcançando a especificação de modelo “ASL-3” da Anthropic.

Tanto o Opus 4 quanto o Sonnet 4 são modelos “híbridos”, afirma a Anthropic — capazes de respostas quase instantâneas e de um pensamento prolongado para uma raciocínio mais profundo (até onde a IA pode “raciocinar” e “pensar” como os humanos entendem esses conceitos). Com o modo de raciocínio ativado, os modelos podem levar mais tempo para considerar possíveis soluções para um determinado problema antes de responder.

Enquanto os modelos raciocinam, eles exibirão um resumo “amigável ao usuário” de seu processo de pensamento, afirma a Anthropic. Por que não mostrar tudo? Parcialmente para proteger as “vantagens competitivas” da Anthropic, admitiu a empresa em um rascunho de blog fornecido ao TechCrunch.

O Opus 4 e o Sonnet 4 podem usar várias ferramentas, como mecanismos de busca, em paralelo, e alternar entre raciocínio e ferramentas para melhorar a qualidade de suas respostas. Eles também podem extrair e salvar fatos na “memória” para lidar com tarefas de forma mais confiável, construindo o que a Anthropic descreve como “conhecimento tácito” ao longo do tempo.

Para tornar os modelos mais amigáveis aos programadores, a Anthropic está lançando atualizações para o mencionado Claude Code. O Claude Code, que permite que os desenvolvedores executem tarefas específicas através dos modelos da Anthropic diretamente de um terminal, agora se integra com IDEs e oferece um SDK que permite conectar aos aplicativos de terceiros.

O SDK do Claude Code, anunciado no início desta semana, possibilita executar o Claude Code como um subprocesso em sistemas operacionais compatíveis, fornecendo uma maneira de construir assistentes de codificação e ferramentas alimentadas por IA que aproveitam as capacidades dos modelos Claude.

A Anthropic lançou extensões e conectores do Claude Code para o VS Code da Microsoft, JetBrains e GitHub. O conector do GitHub permite que os desenvolvedores tagueiem o Claude Code para responder ao feedback dos revisores, assim como tentar corrigir erros ou modificar o código.

Modelos de IA ainda lutam para codificar software de qualidade. A IA geradora de código tende a introduzir vulnerabilidades de segurança e erros, devido a fraquezas em áreas como a capacidade de entender lógica de programação. No entanto, sua promessa de aumentar a produtividade da codificação está levando empresas — e desenvolvedores — a adotá-las rapidamente.

A Anthropic, totalmente ciente disso, promete atualizações mais frequentes dos modelos.

“Estamos … mudando para atualizações de modelo mais frequentes, entregando um fluxo constante de melhorias que trazem capacidades revolucionárias para os clientes mais rapidamente,” escreveu a startup em seu rascunho de post. “Essa abordagem mantém você na vanguarda à medida que continuamente refinamos e aprimoramos nossos modelos.”

Conteúdo relacionado

Anthropic enfrenta reação negativa devido ao comportamento do Claude 4 Opus, que contata autoridades e imprensa se suspeitar de ações “egregiamente imorais”.

[the_ad id="145565"] Junte-se aos nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de liderança no setor. Saiba…

Iliana Quinonez do Google Cloud sobre como escalar startups de IA na Sessions: AI

[the_ad id="145565"] No mundo das startups, o acesso a ferramentas inovadoras não é o maior obstáculo — e sim saber como utilizá-las com precisão. No TechCrunch Sessions: AI,…

Artemis Seaford e Ion Stoica abordam a crise ética na Sessions: IA

[the_ad id="145565"] À medida que a IA generativa se torna mais rápida, acessível e convincente, as questões éticas não são mais teóricas. O que acontece quando as ferramentas…