Participe do evento confiável por líderes empresariais há quase duas décadas. O VB Transform reúne pessoas que constroem verdadeiramente estratégias de IA empresarial. Saiba mais

A potência europeia em IA, a Mistral lançou hoje o Magistral, uma nova família de modelos de linguagem de grande porte (LLMs) que marca a primeira entrada da empresa no espaço cada vez mais competitivo da “razão”, ou modelos que levam tempo para refletir sobre seu pensamento, a fim de capturar erros e resolver tarefas mais complexas do que os LLMs básicos baseados em texto.

O anúncio apresenta um lançamento estratégico duplo: um poderoso Magistral Medium proprietário para clientes corporativos e, notavelmente, uma versão open-source de 24 bilhões de parâmetros, o Magistral Small.

Este último lançamento parece calculado para reforçar o compromisso da empresa com suas raízes fundamentais, após um período em que enfrentou críticas por se inclinar mais para modelos fechados e proprietários, como seu Medium 3 para empresas, lançado em maio de 2025.

Um retorno às raízes open source

Em um movimento que certamente será celebrado por desenvolvedores e pela comunidade de IA mais ampla, a Mistral está liberando o Magistral Small sob a permissiva licença open source Apache 2.0.

Esse é um detalhe crucial. Ao contrário de licenças mais restritivas, a Apache 2.0 permite que qualquer pessoa use, modifique e distribua livremente o código-fonte do modelo, mesmo para fins comerciais.

Isso capacita startups e empresas estabelecidas a construir e implantar suas próprias aplicações em cima da mais recente arquitetura de raciocínio da Mistral, sem taxas de licenciamento ou medo de bloqueio do fornecedor.

Essa abordagem aberta é particularmente significativa dado o contexto. Enquanto a Mistral construiu sua reputação em modelos abertos poderosos, seu lançamento recente do Medium 3 como uma oferta puramente proprietária levantou preocupações em alguns setores da comunidade open-source, que temiam que a empresa estivesse se afastando para um ecossistema mais fechado, semelhante a concorrentes como a OpenAI.

O lançamento do Magistral Small sob uma licença tão permissiva serve como uma poderosa narrativa de contraposição, reafirmando a dedicação da Mistral em armar a comunidade aberta com ferramentas de ponta.

Desempenho competitivo contra adversários formidáveis

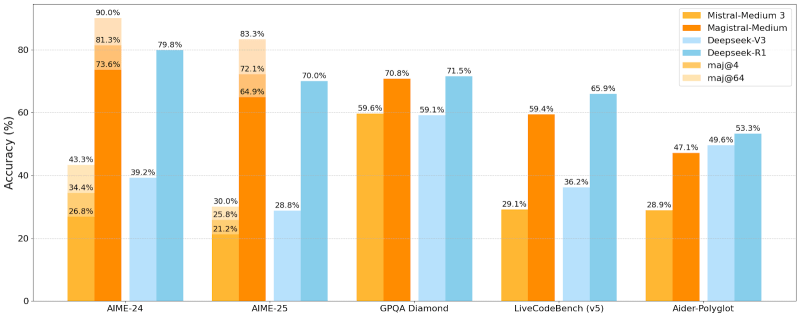

A Mistral não está apenas fazendo grandes promessas; ela trouxe resultados. A empresa divulgou uma série de benchmarks comparando o Magistral-Medium com seu predecessor, Mistral-Medium 3, e concorrentes da Deepseek. Os resultados mostram um modelo que é ferozmente competitivo na arena de raciocínio.

No benchmark de matemática AIME-24, o Magistral-Medium marcou impressionantes 73,6% de precisão, empatando com seu predecessor e superando significativamente os modelos da Deepseek. Ao usar votação majoritária (uma técnica onde o modelo gera várias respostas e a mais comum é escolhida), seu desempenho no AIME-24 salta para impressionantes 90%.

O novo modelo também se destaca em outros testes exigentes, incluindo o GPQA Diamond, um benchmark de perguntas e respostas de nível de pós-graduação, e LiveCodeBench para desafios de programação.

Embora o Deepseek-V3 mostre forte desempenho em alguns benchmarks, o Magistral-Medium consistentemente se prova ser um modelo de raciocínio de alto nível, validando as alegações da Mistral sobre suas capacidades avançadas.

Poder empresarial

Enquanto o Magistral Small atende ao mundo open-source, o Magistral Medium validado por benchmarks é voltado diretamente para o setor empresarial.

Ele está acessível por meio da interface Le Chat da Mistral e da API La Plateforme, oferecendo o desempenho de alto nível necessário para tarefas críticas.

A Mistral está disponibilizando este modelo nas principais plataformas em nuvem, incluindo Amazon SageMaker, com Azure AI, IBM WatsonX e Google Cloud Marketplace a seguir.

Essa estratégia de lançamento dual permite que a Mistral tenha o melhor dos dois mundos: fomentar um ecossistema vibrante em torno de seus modelos abertos enquanto monetiza sua tecnologia mais poderosa e testada em termos de desempenho para clientes corporativos.

Comparação de custos

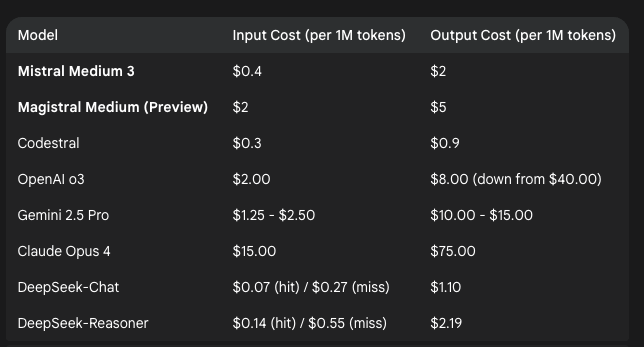

Em termos de custo, a Mistral está posicionando o Magistral Medium como uma oferta distinta e premium, mesmo em comparação com seus próprios modelos.

Com um custo de $2 por milhão de tokens de entrada e $5 por milhão de tokens de saída, representa um aumento significativo de preço em relação ao Mistral Medium 3 mais antigo, que custava apenas $0,40 por entrada e $2 por saída.

No entanto, em comparação com seus concorrentes externos, a estratégia de preços do Magistral Medium parece bastante agressiva. O custo de entrada é equivalente ao do modelo mais recente da OpenAI e se situa dentro da faixa do Gemini 2.5 Pro, mas seu preço de saída de $5 subcarta ambos, que estão na faixa de $8 e acima de $10, respectivamente.

Enquanto é consideravelmente mais caro do que modelos especializados como o DeepSeek-Reasoner, é uma ordem de magnitude mais barato do que o modelo principal Claude Opus 4 da Anthropic, tornando-se uma proposta de valor atraente para clientes que buscam raciocínio de última geração sem pagar os preços mais elevados do mercado.

Raciocínio que você pode visualizar, entender e usar

A Mistral está destacando três vantagens principais com a linha Magistral: transparência, multilinguismo e velocidade.

Quebrando a natureza “caixa-preta” de muitos modelos de IA, o Magistral foi projetado para produzir uma “cadeia de pensamento” rastreável. Isso permite que os usuários sigam o caminho lógico do modelo, um recurso crítico para campos profissionais de alto risco, como direito, finanças e saúde, onde conclusões devem ser verificáveis.

Além disso, essas capacidades de raciocínio são globais. A Mistral enfatiza a “destreza multilíngue” do modelo, destacando o desempenho de alta fidelidade em idiomas como francês, espanhol, alemão, italiano, árabe, russo e chinês simplificado.

No que diz respeito ao desempenho, a empresa alega um grande aumento de velocidade. Um novo “Modo de Pensar” e o recurso “Respostas Rápidas” na interface Le Chat permitem que o Magistral Medium alcance até 10 vezes a taxa de transferência de tokens de seus concorrentes, facilitando o raciocínio em tempo real em uma escala previamente inédita.

De geração de código a estratégia criativa e além

As aplicações para o Magistral são vastas. A Mistral está visando qualquer caso de uso que exija precisão e pensamento estruturado, desde modelagem financeira e análise legal até arquitetura de software e engenharia de dados. A empresa até demonstrou a capacidade do modelo de gerar uma simulação física em uma única tentativa, demonstrando sua compreensão de sistemas complexos.

Mas não é tudo negócios. A Mistral também recomenda o modelo como um “companheiro criativo” para redação e narrativa, capaz de produzir trabalhos que são altamente coerentes ou, como a empresa descreve, “deliciosamente excêntricos.”

Com o Magistral, a Mistral AI está fazendo um movimento estratégico para não apenas competir, mas liderar na próxima fronteira da IA. Ao reengajar sua base open-source com um modelo poderoso e licenciado permissivamente, enquanto simultaneamente empurra os limites do desempenho de nível empresarial, a empresa está sinalizando que o futuro da IA de raciocínio será poderoso e, de uma maneira significativa, aberto a todos.

Insights diários sobre casos de uso empresarial com o VB Daily

Se você quer impressionar seu chefe, o VB Daily tem o que você precisa. Oferecemos a você as informações sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implantações práticas, para que você possa compartilhar insights para um máximo de ROI.

Leia nossa Política de Privacidade

Obrigado por assinar. Confira mais newsletters do VB aqui.

Um erro ocorreu.

Conteúdo relacionado

Os modelos de raciocínio realmente pensam ou não? Pesquisa da Apple gera um debate acalorado.

[the_ad id="145565"] Participe do evento confiável pelos líderes empresariais há quase duas décadas. O VB Transform reúne pessoas que constroem uma verdadeira estratégia de IA…

Além da arquitetura GPT: Por que a abordagem de Difusão do Google pode redefinir a implementação de LLMs

[the_ad id="145565"] Participe do evento confiável por líderes empresariais há quase duas décadas. O VB Transform reúne pessoas que estão construindo uma verdadeira estratégia…

O Ato RISE do Senador exigiria que desenvolvedores de IA listassem dados de treinamento e métodos de avaliação em troca de ‘porto seguro’ contra processos judiciais.

[the_ad id="145565"] Participe do evento confiável por líderes empresariais há quase duas décadas. O VB Transform reúne as pessoas que estão construindo uma verdadeira…