A AMD revelou sua visão abrangente de uma plataforma de IA integrada de ponta a ponta e apresentou sua infraestrutura de IA em rack escalável, aberta e baseada em padrões da indústria durante seu evento anual Advancing AI.

A fabricante de chips, localizada em Santa Clara, Califórnia, anunciou seus novos aceleradores AMD Instinct MI350 Series, que são quatro vezes mais rápidos em computação de IA e 35 vezes mais rápidos em inferência do que os chips anteriores.

A AMD e seus parceiros demonstraram produtos baseados em AMD Instinct e o contínuo crescimento do ecossistema AMD ROCm. Também foram apresentados seus novos e poderosos designs de rack escaláveis e uma folha de roadmap que traz desempenho de liderança em Rack Scale AI além de 2027.

“Podemos agora dizer que estamos no ponto de inflexão da inferência, e isso será o motor,” disse Lisa Su, CEO da AMD, em uma palestra no evento Advancing AI.

Encerrando, em um ataque a Nvidia, ela afirmou: “O futuro da IA não será construído por uma única empresa ou dentro de um sistema fechado. Ele será moldado pela colaboração aberta em toda a indústria, com todos trazendo suas melhores ideias.”

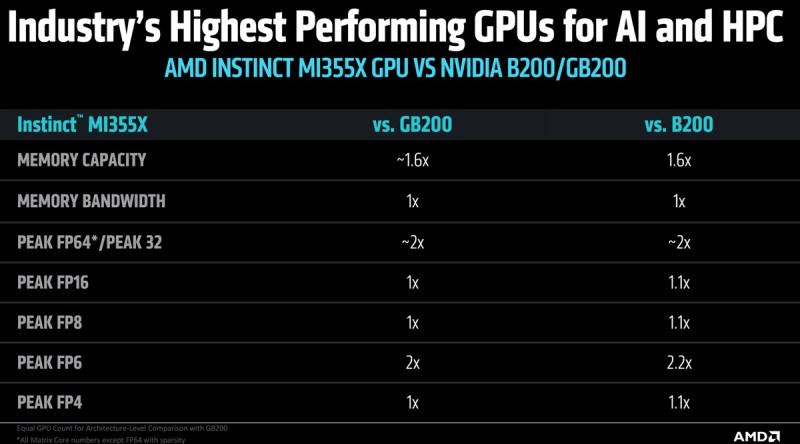

A AMD apresentou as GPUs da série Instinct MI350, estabelecendo um novo padrão para desempenho, eficiência e escalabilidade em IA generativa e computação de alto desempenho. A série MI350, composta pelas GPUs Instinct MI350X e MI355X, oferece um aumento de quatro vezes na computação de IA geração a geração e um salto de 35 vezes na inferência, abrindo caminho para soluções transformadoras de IA em diversas indústrias.

“Estamos muito empolgados com o trabalho que vocês estão fazendo na AMD,” disse Sam Altman, CEO da Open AI, no palco com Lisa Su.

Ele afirmou que não podia acreditar quando soube das especificações do MI350 da AMD, e estava agradecido por a AMD ter levado em conta o feedback de sua empresa.

A AMD demonstrou uma infraestrutura de IA em rack com padrões abertos—já em implantação com os aceleradores da série AMD Instinct MI350, processadores AMD Epyc de 5ª geração e placas de interface de rede (NICs) AMD Pensando Pollara em implementações em hyperscalers, como a Oracle Cloud Infrastructure (OCI), com disponibilidade ampla prevista para o segundo semestre de 2025. A AMD também apresentou sua próxima geração de rack de IA, chamada Helios.

Ele será construído com as GPUs AMD Instinct MI400 Series de próxima geração, os CPUs AMD Epyc Venice baseados na arquitetura Zen 6 e os NICs AMD Pensando Vulcano.

“Acho que eles estão mirando um tipo diferente de cliente do que a Nvidia,” disse Ben Bajarin, analista da Creative Strategies, em uma mensagem ao GamesBeat. “Especificamente, penso que eles veem a oportunidade do neocloud e uma série de clouds de nível dois e três, além das implantações de empresas on-premise.”

Bajarin acrescentou, “Estamos otimistas com a mudança para sistemas de implementação em rack completos e é aí que o Helios se encaixa, o que alinhará com a temporalidade do Rubin. Mas à medida que o mercado muda para a inferência, no que estamos apenas começando, a AMD está bem posicionada para competir e capturar uma fatia. Também acho que há muitos clientes por aí que darão valor ao TCO da AMD, onde agora a Nvidia pode ser excessiva para suas cargas de trabalho. Portanto, essa é uma área a ser observada, que novamente se relaciona a quem é o cliente certo para a AMD, e pode ser um perfil de cliente bem diferente do cliente da Nvidia.”

A última versão da pilha de software de IA de código aberto da AMD, ROCm 7, foi projetada para atender às crescentes demandas de cargas de trabalho de IA generativa e computação de alto desempenho—enquanto melhora dramaticamente a experiência do desenvolvedor em geral. (Radeon Open Compute é uma plataforma de software de código aberto que permite a computação acelerada por GPU em GPUs AMD, especialmente para computação de alto desempenho e cargas de trabalho de IA). O ROCm 7 apresenta suporte aprimorado para frameworks padrão da indústria, compatibilidade de hardware expandida e novas ferramentas de desenvolvimento, drivers, APIs e bibliotecas para acelerar o desenvolvimento e a implantação de IA.

Em sua palestra, Su afirmou: “A abertura deve ser mais do que apenas uma palavra da moda.”

A série Instinct MI350 superou a meta de cinco anos da AMD de melhorar a eficiência energética de nós de treinamento de IA e computação de alto desempenho em 30 vezes, entregando, na verdade, uma melhoria de 38 vezes. A AMD também revelou uma nova meta para 2030 de entregar um aumento de 20 vezes na eficiência energética em rack, a partir de um ano base de 2024, permitindo que um modelo típico de IA, que hoje requer mais de 275 racks para ser treinado, seja treinado em menos de um rack totalmente utilizado até 2030, utilizando 95% menos eletricidade.

A AMD também anunciou a ampla disponibilidade do AMD Developer Cloud para as comunidades global de desenvolvedores e de código aberto. Construído especificamente para desenvolvimento de IA rápido e de alto desempenho, os usuários terão acesso a um ambiente de nuvem totalmente gerenciado, com as ferramentas e a flexibilidade para começar com projetos de IA — e crescer sem limites. Com o ROCm 7 e o AMD Developer Cloud, a AMD está reduzindo barreiras e expandindo o acesso à computação de próxima geração. Colaborações estratégicas com líderes como Hugging Face, OpenAI e Grok estão demonstrando o poder de soluções abertas co-desenvolvidas. O anúncio gerou aplausos de alguns presentes, já que a empresa afirmou que daria créditos de desenvolvedor aos participantes.

Ecossistema de Parceiros Amplo Mostra o Progresso em IA Impulsionado pela AMD

Clientes da AMD discutiram como estão utilizando soluções de IA da AMD para treinar os modelos de IA mais avançados de hoje, potencializar a inferência em escala e acelerar a exploração e o desenvolvimento de IA.

A Meta detalhou como tem aproveitado várias gerações de soluções AMD Instinct e Epyc em sua infraestrutura de data center, com o Instinct MI300X amplamente implantado para inferência Llama 3 e Llama 4. A Meta continua a colaborar de perto com a AMD em roadmaps de IA, incluindo planos para utilizar as GPUs e plataformas da série MI350 e MI400.

A Oracle Cloud Infrastructure está entre os primeiros líderes da indústria a adotar a infraestrutura de IA em rack escalável da AMD com as GPUs AMD Instinct MI355X. A OCI utiliza CPUs e GPUs da AMD para oferecer desempenho escalável e balanceado para clusters de IA, e anunciou que oferecerá clusters de IA zettascale acelerados pelos mais recentes processadores AMD Instinct, com até 131.072 GPUs MI355X para permitir que clientes construam, treinem e inferem IA em larga escala.

A Microsoft anunciou que o Instinct MI300X agora está alimentando tanto modelos proprietários quanto de código aberto em produção na Azure.

A HUMAIN discutiu seu acordo histórico com a AMD para construir uma infraestrutura de IA aberta, escalável, resiliente e de custo eficiente, aproveitando todo o espectro de plataformas de computação que apenas a AMD pode fornecer. A Cohere compartilhou que seus modelos Command de alto desempenho e escaláveis estão implementados no Instinct MI300X, potencializando a inferência de LLM de nível empresarial com alta taxa de transferência, eficiência e privacidade de dados.

Na palestra, a Red Hat descreveu como sua colaboração expandida com a AMD possibilita ambientes de IA prontos para produção, com GPUs Instinct da AMD na Red Hat OpenShift AI, oferecendo processamento poderoso e eficiente de IA em ambientes de nuvem híbrida.

“Eles podem tirar o máximo proveito do hardware que estão usando”, disse o executivo da Red Hat no palco.

A Astera Labs destacou como o ecossistema aberto UALink acelera a inovação e entrega maior valor aos clientes, além de compartilhar planos para oferecer um portfólio abrangente de produtos UALink para apoiar a infraestrutura de IA da próxima geração. A Marvell se juntou à AMD para compartilhar o roadmap do switch UALink, o primeiro interconector verdadeiramente aberto, trazendo a máxima flexibilidade para a infraestrutura de IA.

Conteúdo relacionado

Os modelos de raciocínio realmente pensam ou não? Pesquisa da Apple gera um debate acalorado.

[the_ad id="145565"] Participe do evento confiável pelos líderes empresariais há quase duas décadas. O VB Transform reúne pessoas que constroem uma verdadeira estratégia de IA…

Além da arquitetura GPT: Por que a abordagem de Difusão do Google pode redefinir a implementação de LLMs

[the_ad id="145565"] Participe do evento confiável por líderes empresariais há quase duas décadas. O VB Transform reúne pessoas que estão construindo uma verdadeira estratégia…

O Ato RISE do Senador exigiria que desenvolvedores de IA listassem dados de treinamento e métodos de avaliação em troca de ‘porto seguro’ contra processos judiciais.

[the_ad id="145565"] Participe do evento confiável por líderes empresariais há quase duas décadas. O VB Transform reúne as pessoas que estão construindo uma verdadeira…